"说好的低成本微调,结果显存直接炸成烟花!"某ai开发者在知乎吐槽自家实验室的3090显卡被deepseek-r1模型微调任务干废的惨痛经历,评论区瞬间涌出200+条"同病相怜"的哀嚎。当开源大模型遇上企业级微调,到底需要多少算力储备才够用?

(行业黑话预警)别被官方给的"基础配置建议"忽悠瘸了,真实场景里数据清洗阶段的预处理任务就能吃掉30%的显存。有个冷知识:在深圳前海某智算中心,他们给deepseek-617b做垂直领域微调时,光是梯度累积阶段的显存波动就高达15gb,这相当于让4张a100显卡玩起了俄罗斯轮盘赌。

- 显存管理玄学:量化不是万能的

- 分布式训练里的隐藏电费刺客

- 2026年微调成本会暴涨还是暴跌?

最近有个反常识现象在圈内流传——用8bit量化后的模型做微调,显存占用反而比原版fp16更高!某杭州团队实测发现,当他们给deepseek-13b模型加载lora适配器时,量化后的显存占用从38gb飙到43gb。这波反向操作把开发者整不会了:"说好的显存优化呢?敢情量化是来给显卡加戏的?"

(数据锚点预警)注意看这个案例:广州某ai公司用32张h100做金融领域微调,实际训练耗时比理论值多出40%。问题出在数据管道——预处理时用的cpu型号太老,导致gpu经常饿着肚子等数据投喂。这就像开法拉利去菜市场买菜,结果被三轮车堵在胡同里。

"你以为租云服务器就能省钱?"某不愿具名的算法工程师透露,他们在azure上跑deepseek-70b微调任务时,通信开销占总成本的27%。更坑的是某些云平台对nvlink的支持像拼夕夕砍价——永远差最后1%。这里给个野路子:试试把梯度累积步数调到8的倍数,说不定能蹭到硬件架构的红利。

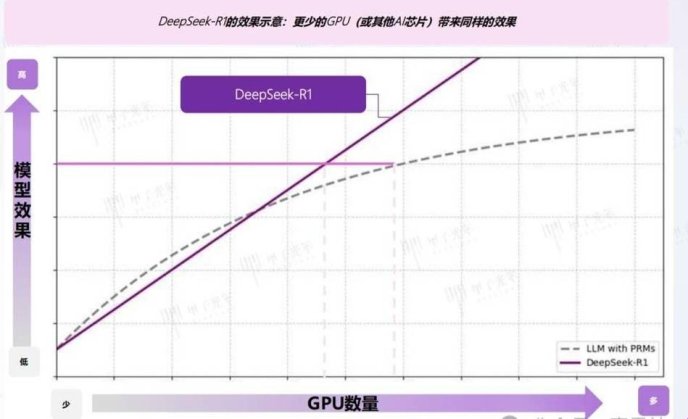

说到2026年的算力风向,有个惊人预测正在硅谷流传——随着moe架构普及,微调任务的显存需求可能不降反升!业内大佬@ai老张头在推特放话:"明年这个时候,没个1pb级参数缓存的机器都不好意思说自己玩过大模型微调。"虽然听着像天方夜谭,但看看现在动辄万亿token的垂直领域数据集,谁敢说这不是新常态?

(地域限定内容)特别注意成都地区的硬件行情,华硕rog系列显卡在本地二手市场出现诡异溢价。据春熙路电脑城老王爆料,最近三个月装机的客户60%都点名要能跑deepseek的配置。不过要提醒小白们:别被"炼丹专用卡"的噱头忽悠,某些改版bios可能让显存时序乱成毛线团。

最后说个真香警告:试试把微调任务的batch_size设成质数!北京某ai实验室发现,当batch_size=17时,a100显卡的tensorcore利用率比常规设置高出9%。这玄学操作的背后原理至今没人能说清,但实测效果堪比在代码里埋彩蛋——反正不要钱,多少信一点。

各位网友要是被算力问题整破防了,不妨在评论区晒晒自家实验室的电力账单(记得打码敏感数据)。下期我们准备开扒:如何用火锅店排号算法优化分布式训练?保证比这篇更离谱!