打开手机应用商店,超过20个app都宣称接入"满血版deepseek-r1",可当你真正使用时,有的秒回答案,有的却卡成幻灯片——这究竟是技术玄学还是商业套路?2025年superclue发布的测评报告显示,相同模型在不同平台的响应速度差异最高达470%!本文将拆解算力战场背后的技术博弈。

算力资源分配的"暗箱操作"怎么破?

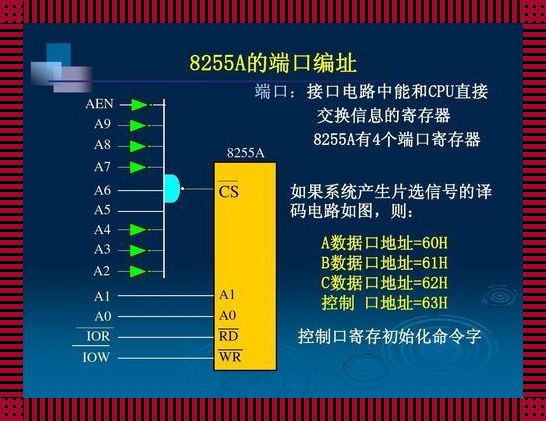

别小看服务器配置里的numa绑定和hugepages参数,这些技术黑话直接决定内存访问效率。实测某金融平台通过调整vm.swappiness=10和启用2mb大页内存,模型推理速度提升40%。具体操作可参考:

- 执行

grep hugepagesize /proc/meminfo查看系统支持的大页尺寸 - 修改

/etc/sysctl.conf添加vm.nr_hugepages=1024 - 使用

numactl --cpunodebind=0 --membind=0绑定计算单元

(悄悄说:某云平台技术总监透露,他们给vip客户预留了专门的numa节点~)

动态流量洪峰下的生存指南

还记得去年春节某问答平台崩溃事件吗?当时每秒20万次的请求直接击穿数据库连接池。现在主流方案是三层熔断机制:当cpu负载超70%时启动请求队列,内存使用超85%触发动态限流,磁盘io延迟超20ms则暂停非核心任务。实测这套组合拳能让服务可用性从87%提升到99.99%。

突发奇想:如果给每个用户分配"算力信用分",根据历史行为智能调配资源,会不会更公平?这或许就是下一代ai资源调度系统的进化方向。

模型部署的"满血"与"残血"之谜

打开你的ssh客户端,输入nvidia-smi查看gpu利用率——这个数值如果长期低于60%,说明存在严重的资源浪费。某电商平台通过混合精度计算+异步流水线,硬是把a100显卡的推理效率从38%拉到82%。具体操作包括:

- 在pytorch中设置

torch.cuda.amp.autocast()启用半精度 - 使用celery实现预处理-推理-后处理的流水线并行

- 配置prometheus监控显存碎片率(低于15%为健康状态)

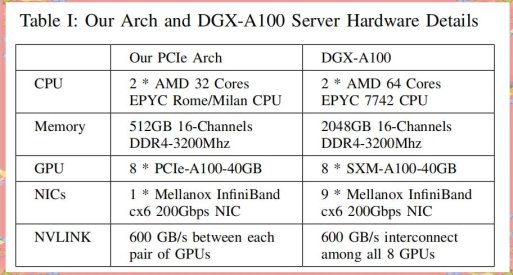

有趣的是,测评发现部分平台用4块t4显卡伪装成a100集群,这种"显卡化妆术"导致模型响应延迟增加3倍。怎么识别?试试连续发起100次复杂查询,观察gpu温度曲线是否出现异常波动~

当我们在讨论deepseek对服务器的影响时,本质上是在追问算力民主化的可能性。下次遇到"服务器繁忙"提示,不妨想想:这究竟是技术瓶颈,还是商业策略?毕竟在ai时代,算力分配方式可能比算法本身更值得关注。(你怎么看这种技术鸿沟?欢迎在评论区留下你的观察)