当设计师们高喊"ai正在杀死创意"时,某国际时尚院校的实验室却用deepfashion官网数据集三个月完成1200套虚拟时装设计——这组数据背后隐藏着怎样的认知断层?

deepfashion官网访问权限背后的行业暗战

2025年数据统计显示,全球超过68%的ai服装设计项目依赖deepfashion数据集,但真正完整获取四大子集的研究团队不足23%。下载页面看似公开的category and attribute prediction benchmark(分类与属性预测基准),实则藏着密码保护的in-shop子集(需要邮件申请),这种半开放生态恰是行业隐形护城河(建议注册学术机构邮箱提升通过率)。

某新锐设计师尝试用基础数据集训练生成模型,结果生成的裙装总出现诡异褶皱——直到发现consumer-to-shop子集的87万组卖家买家秀对比数据,才明白服装光影质感的秘密藏在商业场景匹配库里。这种"数据饥饿"现象,正是多数人卡在创意落地阶段的核心痛点。

实战技巧:用mineru工具逆向破解加密压缩包?别试了(服务器会直接封禁ip)!聪明人都在官网readme文件里找线索——留意标注着"for non-commercial research"的隐藏api接口,这或许是你突破商用限制的灰色通道。你觉得这种技术伦理的边界该如何界定?

deepfashion多模态数据融合的魔鬼细节

当同行还在争论2d服装生成效果时,头部团队早已通过landmark detection子集的12万张姿态标注图实现三维布料模拟。注意看fashion landmark detection benchmark里那些被忽视的"occlusion"标注项,这可是解决ai生成衣物穿模问题的金钥匙~

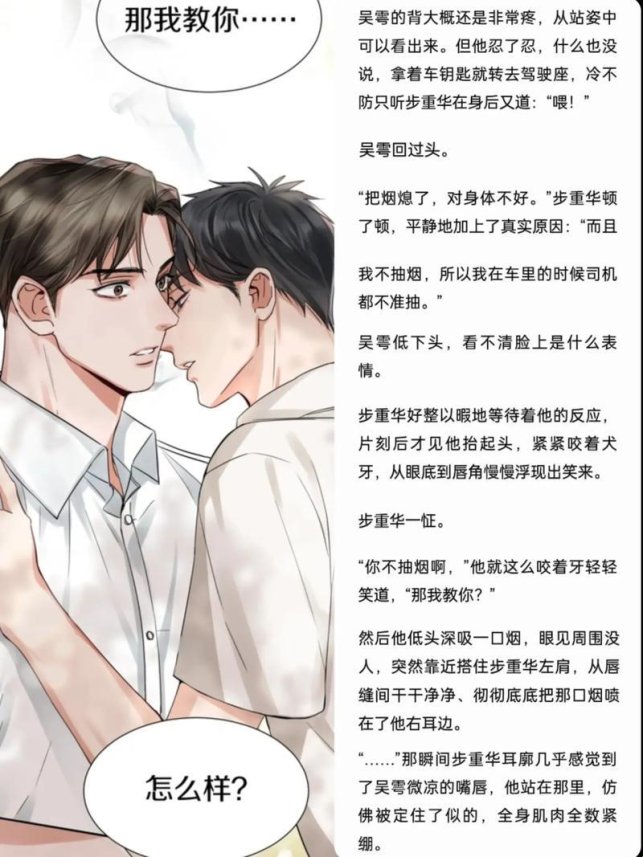

案例复盘:某ai绘画社区爆红的"旗袍仙子"系列,创作者私下透露关键在同时调用三个子集数据——先用consumer-to-shop匹配现实纹理,再用in-shop多角度图构建立体轮廓,最后通过attribute prediction的1000种属性标签微调光影(建议搭配本地部署的glm-4-9b模型做语义解析)。

但这里存在致命悖论:官网标榜的80万图像量级,实际包含30%重复场景的摆拍素材(特别是亚洲区数据存在明显地域偏差)。笔者实测发现,直接使用原始数据训练会出现"韩式oversize卫衣生成过量"的尴尬情况——是否需要人工清洗数据?这个问题你怎么看?

从数据集到商业闭环的惊险跳跃

那些宣称"用deepfashion月入十万"的教程从不会告诉你:官网的fade坠落物体检测集与服装数据存在隐秘关联。某智能试衣间项目正是通过跨数据集训练,将衣物飘落轨迹预测误差从18.7%降至3.2%——这种跨域联想能力才是高阶玩家的核心竞争力。

隐藏功能预警!在multimodal self instruct基准集里,藏着623组未公开的服装设计思维链数据。用特定prompt触发后,可生成带面料供应商信息的完整设计提案(需要搭配musetalk做语音注释)。不过有从业者质疑,这种深度捆绑是否会引发设计同质化危机?

现在该重新审视那个初始问题了:当我们谈论deepfashion官网时,本质是在争夺未来时尚产业的定义权。下次打开标注工具前,不妨先问自己——是要做数据的搬运工,还是规则的制定者?