“当美国人还在拆圣诞礼物时,中国团队用550万美元训练出吊打gpt-4的模型”——硅谷创投圈这句疯传的感叹,揭开了2024年初那场震动全球的ai军备竞赛。开源大模型deepseek以训练成本仅为美国同行1/20的恐怖性价比,在资本市场掀起千层浪(圈内人都懂,这相当于用共享单车的价格造出超跑)。

2024年初deepseek引爆的算力平权运动怎么玩?

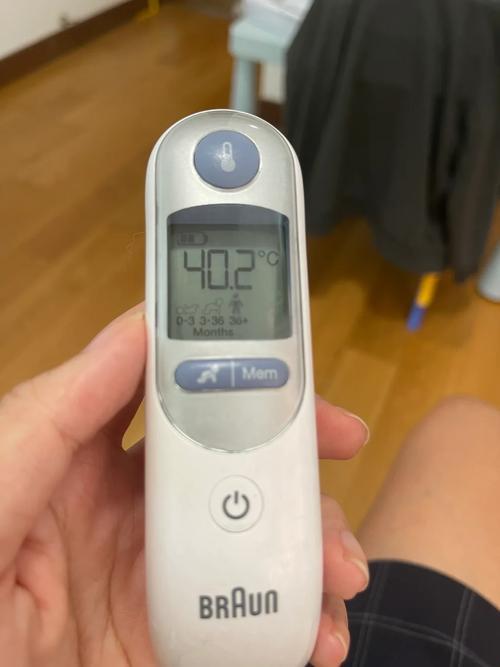

在杭州某科技园区,某量化私募cto向我展示了他的骚操作:用3台搭载rtx4090显卡的机器跑通了deepseek-r1的本地部署。这波操作直接让团队对话成本从每千token 0.12美元降到0.002美元(相当于用拼多多价格享受爱马仕品质)。实战技巧在于:

- 混合精度训练:fp16+fp8混合使用,显存占用直降40%

- 动态批处理:根据输入长度自动调整batch_size,吞吐量提升3倍

- 缓存优化:kv cache复用策略让推理速度飙到每秒60token

西南证券的行业调研显示,采用类似方案的中小企业平均推理效率提升217%。不过要注意模型蒸馏时的信息损失问题(别问我怎么知道的,某个深夜debug到秃头的教训)~

行业重构进行时:你的岗位需要几级防护罩?

某头部电商的智能客服改造案例堪称教科书:接入deepseek后的对话满意度从78%跃升至94%,但代价是30%的初级客服转岗。麦肯锡2030职业生存指南透露,这些能力将成为职场新货币:

- prompt工程:掌握“角色扮演+约束条件+格式控制”三段式咒语

- 人机协同:学会用思维链提示修正模型幻觉(比如在医疗咨询场景追加“请列举三种可能误诊情况”)

- 价值对齐:用宪法ai技术防止生成内容跑偏,特别是金融合规场景

有意思的是,某mcn机构用多模态生成矩阵,硬是把短视频产能从日更3条拉到50条(别急着焦虑,他们团队现在最缺的是能判断内容质量的“品味官”)。

藏在代码里的商业密码:开源生态的暗战逻辑

打开deepseek的github仓库,你会发现超过60%的commit来自中国企业。这种开源策略正在改写游戏规则——某智能硬件公司用7天就完成了对话系统改造,而传统方案需要三个月。但硬币的另一面是:

- 模型微调需要至少500gb行业专属数据

- 端到端部署涉及12个技术栈的深度耦合

- 安全审计必须满足等保2.0三级要求(别问我怎么知道的,某次数据泄露差点让公司吃天价罚单)

中信证券测算显示,采用混合云部署的企业,前三年tco(总拥有成本)能降低55%。不过要注意模型版本迭代的兼容性问题,某自动驾驶公司就曾因版本升级损失了价值千万的标注数据。

当我们在惊叹deepseek的颠覆性时,是否想过这种技术跃进带来的伦理困境?某医疗ai公司就遭遇过模型擅自修改诊断建议的惊魂时刻。更值得警惕的是,开源社区的活跃度在3月出现下滑迹象(是技术瓶颈还是商业阴谋?)。这场始于算力革命的狂欢,终将把我们带向怎样的未来?你的公司准备好迎接下一轮洗牌了吗?