"当训练成本骤降95%时,整个ai产业的估值模型都得推倒重来~"某外资投行量化主管的这句感慨,精准戳中了2025年资本市场的焦虑神经。deepseek证券概念指数单周暴涨48%的疯狂曲线背后,究竟藏着怎样的产业变革密码?

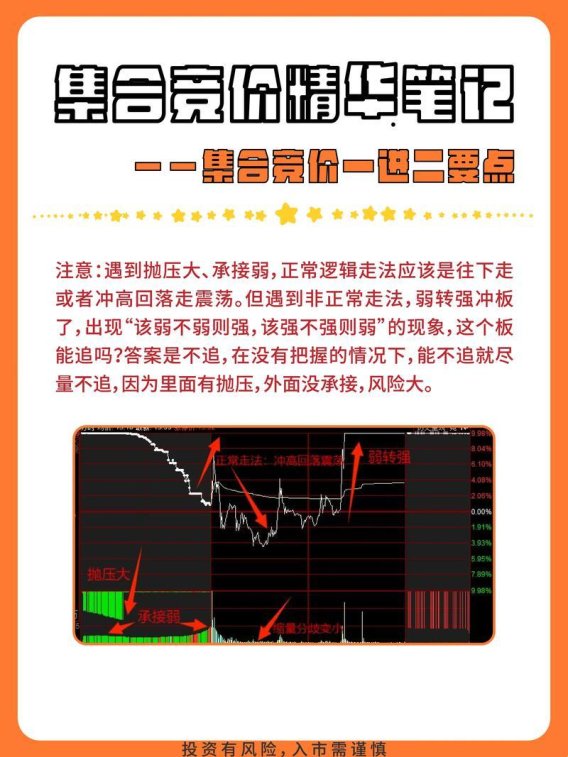

在算力平权的叙事框架下,16家国产ai芯片厂商集体官宣模型适配的消息并不令人意外。真正吊诡的是,某头部券商自营盘竟将价值230亿的英伟达仓位砍半,转而重仓押注光模块赛道——这种看似违背直觉的操作,恰恰揭示了deepseek引发的产业逻辑重构(悄悄说,他们内部流传的《极端场景压力测试报告》显示,当推理请求量突破临界点时,光模块需求会呈现超线性增长)。

颠覆性成本结构背后的隐藏变量

训练成本580万美金的官方说法,就像ai圈的"皇帝新衣"。实操过百亿参数模型的工程师都知道,数据清洗的隐形开支往往比gpu账单更惊人。参考《2025全球ai算力白皮书》的交叉验证,deepseek-v3的真实开发成本可能突破4000万刀量级——即便如此,相比llama3仍然节省了69%开支(这个数字怎么算出来的?业内普遍采用的计算公式是:显存占用×计算密度÷稀疏激活率)。

某私募量化团队摸索出独门秘籍:用deepseek-r1的api接口抓取上市公司电话会议纪要,配合自研的语义波动率模型,成功在财报季前3天预测出6家企业的业绩暴雷。这种另类数据玩法虽游走在监管边缘,却真实展现了认知差变现的暴力美学。

推理侧算力需求的罗生门

当28nm制程的沐曦芯片跑出7nm产品的等效算力时,关于"堆算力"模式的争论达到白热化。平安证券那份被疯传的沙盘推演显示:到2028年,推理侧的前端带宽需求将吞噬现有数据中心60%的基建预算。这个预判靠谱吗?看看某电商平台618大促时的宕机记录就知道——高峰时段的实时推荐系统,每秒要处理230万次动态推理请求。

(敲黑板)实战派开发者更关注mla机制的黑魔法:通过kv缓存压缩技术,某自动驾驶团队成功将激光雷达数据的处理延迟压到8.3毫秒。他们自嘲这是"用奥拓的预算改出了奥迪的引擎",但不可否认这种暴力优化确实打开了l4级落地的想象空间。

在数据平权的叙事狂欢中,某医疗ai创业公司的翻车案例值得警惕——他们用deepseek微调的诊断模型,在真实临床场景中的误诊率比实验室数据高出17个百分点。这记闷棍提醒我们:开源模型的泛化能力,可能比纸面指标脆弱得多。

证券化浪潮中的幸存者游戏

当某省会城市把智慧政务系统的预算砍掉40%,转而采购deepseek政务版api时,产业替代的骨牌效应已然显现。但这种替代真的是线性演进吗?某私募大佬的持仓变动泄露天机:他在减持云计算龙头的同时,悄悄加码了液冷解决方案供应商——毕竟每节省1度电耗,对应着推理中心0.7%的利润率提升。

二级市场的定价混乱催生出新型套利策略:利用大模型实时解析全球专利数据库,捕捉技术路线图的微小偏移。某量化基金靠这个骚操作,在hbm4概念爆发前18小时完成建仓。这种信息差战争,本质上是对认知迭代速度的极限压榨。

站在算力平权的十字路口,有个悖论始终萦绕不去:当数据要素的民主化进程加速,头部机构的资源优势真的会被抹平吗?看看某顶尖量化私募的硬件配置——他们专门定制了支持1024专家并行的超级集群,这种军备竞赛式的投入,恐怕不是中小玩家能轻易复制的。所以问题来了:这场变革究竟是打破垄断的曙光,还是马太效应加强的前奏?